O planejamento e controle de produção é um dos principais desafios vividos pelas indústrias do Brasil e do mundo, pois exige grandes esforços em planejamento e controles e da unificação e análise de informações de Múltiplas Áreas da indústria, sendo algumas delas: (S&OP, PCP, Qualidade, Segurança de Pessoas e de Produtos, Manutenção, Engenharia, Logística e Meio Ambiente).

Além da necessidade de análise de fatores externos, os quais são de extrema importância para algumas atividades, pois tais análises apresentam a necessidade de mudança de direção de forma muito rápida, como é o caso por exemplo de usinas de açúcar e etanol, a quais estão constantemente buscando entender o que é mais rentável produzir no momento: (açúcar, álcool ou eletricidade?), sendo diretamente influenciados por fatores externos.

Conseguir unir custos, prazos, objetivos com agilidade e baixo esforço e ainda, poder simular cenários tendo insights da melhor ação a ser tomada, de forma a aproveitar todo o potencial da planta de forma global e poder acompanhar o planejado x realizado em tempo real, garantindo qualidade, segurança, economia energética e redução de custos de forma global é sem dúvida alguma, um grande desafio!

O sucesso na produção envolve uma série de dificuldades, começando pela previsão de vendas, produção atual da planta, capacidade produtiva, demandas de clientes que já existem, novas demandas, matérias primas, energia, cadeia de fornecedores, ofertas contínuas (força de vendas) e muito mais, além da necessidade de avaliar os diversos fatores externos, como a projeção de crescimento, clima, logística, diversificação de produtos e muito mais. Todos esses esforços demandam muito tempo e dinheiro!

1) “Quais” e “Como” podemos aplicar tecnologias emergentes para aumentar o resultado?

Vivemos uma corrida e uma constante luta para melhorarmos os resultados de nossas empresas e consequentemente, torná-las mais competitivas e lucrativas, ajudando a garantir a perenidade do negócio o qual atuamos ou da empresa a qual fazemos parte.

Das técnicas utilizadas no mercado, destacam-se duas, sendo:

a) Técnicas de controle avançado:

Bastante conhecidas as Técnicas (Fuzzy) e (modelos preditivos) tem sido cada vez mais aplicadas e utilizadas no mercado pelas indústrias de maneira a ganharem maior competitividade, também pelo fato de após prontas para uma aplicação específica demandam menor esforço de implementação e integração, mas é importante destacar que essas técnicas são para aplicações locais e para soluções específicas, como por exemplo: (i) ajuste sistêmico de uma caldeira, (ii) análise, alertas de problemas, possíveis falhas e motores elétricos.

Controle por Lógica Nebulosa (Fuzzy): O uso da lógica nebulosa em conjunto com as técnicas de análise e inferências da inteligência artificial permitiu o desenvolvimento de controladores Fuzzy, em geral este tipo de controlador deve ser desenvolvido com regras e características internas específicas para cada sistema que se deseja controlar.

A lógica Fuzzy não necessita de conhecimento prévio dos fenômenos envolvidos.

Os sistemas atualmente disponíveis no mercado utilizam valores mínimos, médios e máximos dos sensores (temperatura, pressão e fluxo) e dos atuadores (válvulas, bombas e motores) para definir regras que podem ser posteriormente ajustadas, mas não fazem o ajuste global, apenas local.

Controle Preditivo com Otimização: O Algoritmo MPC tem característica preditiva, ou seja, utiliza um modelo interno do processo para prever o comportamento das variáveis dependentes ao longo de um horizonte futuro, em função de variação nas variáveis manipuladas ou perturbações. Este modelo é gerado por meio de testes de variação na própria unidade de processo. Utilizando as predições futuras das variáveis dependentes, o algoritmo calcula os movimentos necessários nas variáveis manipuladas que minimizem a soma dos erros futuros.

b) Técnicas de otimização em tempo real:

As técnicas de otimização em tempo real são mais complexas e demandam maior trabalho e investimento, pois há necessidade de um mapeamento completo da planta onde será aplicada, além da necessidade de mapeamento dos ativos (equipamentos de controle e medição, máquinas), os quais necessitam de seus dados serem imputados e trabalhados para serem otimizados e controlados por essa técnica, por outro lado, é a técnica a qual se aplica na indústria de forma correta, aumentará não apenas os índices de performance produtiva e qualidade (OEE) mas também reduz consideravelmente os custos energéticos e produtivos e a rentabilidade (lucratividade) da empresa que fizer uso dessa tecnologia.

“Algoritmo Otimização em Tempo o Real” é capaz de otimizar o desempenho do processo global (medindo em termos de lucro, custo operacional, análise externas) e permitir que as empresas possam aumentar a sua rentabilidade nas diversas condições da planta alinhando a estratégia corporativa e controle operacional de forma global.

Essa técnica baseia-se na unificação de vários modelos matemáticos na planta para “explorar” e simular regiões da operação atual, e para então encontrar o ponto “ótimo” para a operação, a qual pode ser combinada com a estrutura computacional do AzureStack (solução híbrida da Microsoft “local e nuvem”) e de Tecnologias de Automação e Controle Industrial, com essa combinação o sistema possui a capacidade de atuar diretamente no controle desses equipamentos ajustando para condição de operação “ótima” definida pelo algoritmo para o sistema de controle industrial, entregando assim a melhor performance produtiva para todas as áreas.

Essa técnica pode ser combinada ainda com as técnicas de controle avançado, principalmente se tratando de modelos preditivos de falhas em máquinas.

2) Por onde começar e quais os desafios para implementar um Modelo de Otimização em Tempo Real?

Nós (Dipsie Solutions) acreditamos que os principais desafios para implantação de Modelos de Otimização em Tempo Real estão na capacidade de mudança ou adaptação cultural e por onde e como se começam as atividades para implantação de Modelagem em Tempo Real.

Por se tratar de uma solução tecnológica, na grande maioria das vezes as empresas acabam dando início no projeto pela parte técnica, ou seja, pela parte de engenharia, sendo: coleta de dados, mapeamentos de equipamentos, comunicação de redes existentes e muito mais.

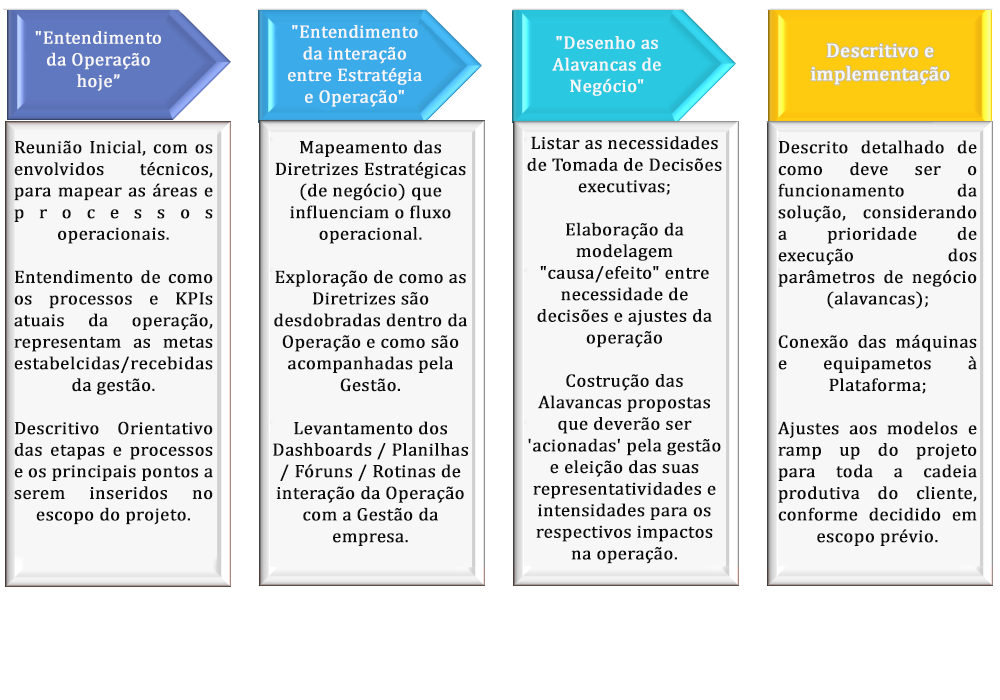

Apresentamos a forma que acreditamos ser a mais viável para a implantação da Modelagem em Tempo Real, tendo seu início no entendimento das formas de atuação da empresa e um diagnóstico e suas etapas; sendo:

a) Entendimento da Operação Hoje (As is):

Usando metodologias aplicadas ao diagnóstico, esta fase destina-se a fazer um completo entendimento, na visão do cliente, de seus principais processos e possíveis gargalos. Nesta etapa devem ser levantadas não apenas as etapas e atividades, como também todo conjunto de ferramentas, programas, e artefatos de governança que deem a visão sistêmica do processo produtivo e possíveis relações de causa-efeito.

O segundo pilar do diagnóstico é o levantamento do conjunto de KPIs usado para medir a performance da operação, buscando entender se os dashboards atuais são efetivos, ou seja, realmente representam o acompanhamento e monitoramento dos processos e indicadores chaves para uma operação sustentável para o negócio. Esse primeiro diagnóstico deverá focar na visão operacional e buscar uma compreensão do quão sistêmico é a visão da operação com os atributos: produtivos, de suprimentos e logísticos.

O “entregável” dessa fase deve ser um descritivo orientativo das etapas e processos com um mapa Operacional Sistêmico, com um Score de Aderência de quanto a operação tem visão do todo e facilidade em adequar suas tarefas frente às demandas e orientações estratégicas da Gestão.

b) Entendimento da Integração entre Estratégia e Operação (As is):

Utilizando os conceitos de Coerência Estratégica, o qual defende a existência de um fluxo conector entre as decisões tomadas em fóruns ‘executivos’ até o ‘chão de fábrica’, essa etapa do diagnóstico irá extrapolar a visão operacional e levantar todos os artefatos e rituais da governança estratégica da empresa e como esses elementos poderão direcionar a criação das “Alavancas Estratégicas”, as quais poderão/deverão servir como norteadores do fluxo operacional.

Para tal, uma vez mapeado o Fluxo Estratégico, esse fluxo será desdobrado até os processos produtivos criando um Mapa Estratégico/Operacional com as relações de causa e efeito, tornando possível a criação do primeiro ‘rascunho’ de quais Alavancas Estratégicas deverão existir.

A analogia é imaginar uma Sala na qual executivos pudessem se reunir para simular e tomar decisões sobre o rumo dos negócios, de acordo com a conjuntura externa baseada nas 11 forças macro e micro ambientais (1.Político, 2.Econômico, 3.Social, 4.Tecnológico, 5.Ambiental, 6.Legal, 7.Concorrência, 8.Fornecedores, 9.Clientes, 10 Novos Entrantes e 11.Substitutos), e nessa mesma sala haveriam “Alavancas” sistêmicas, ordenadas por temas: “Rentabilidade”; “Volume”; “Qualidade”; “Custo Operacional” “Custo Produtivo”, entre outras, as quais pudessem ser ‘puxadas/empurradas’, calibrando em tempo real a velocidade produtiva da fábrica, ou a compra de outro conjunto de insumos, ou usar (+)ou(-) fontes de energia, entre outras possibilidades.

O qual a partir dessa fase inicia-se em paralelo o desenvolvimento e implementação técnica da Solução Modelagem em Tempo Real.

c) Desenho das Alavancas de Negócio (To be):

Passado pela etapa anterior e validando a primeira proposta de Alavancas Estratégicas, nessa fase é necessário realizar os ajustes para configuração dos parâmetros sistêmicos de cada Alavanca e suas possíveis interações no fluxo operacional e produtivo da empresa. Além desses parâmetros, também devem ser calibradas as intensidades de interação para cada Alavanca.

É nessa fase que as primeiras POCs são conduzidas em conjunto com a empresa que estiver implementando, tanto na esfera operacional, quanto estratégica, enxergando possíveis melhorias ou acréscimo de informações que antes passaram desapercebidas.

d) Descritivo e implementação (To be):

Com as análises das POCs ou sistema ALPHA em teste, que foram realizadas na etapa anterior, a próxima etapa visará a aprovação executiva do cliente para: (1) Quais Alavancas Estratégicas; (2) Quais os parâmetros de cada Alavanca Estratégica; (3) Quais intensidades e hierarquia de prioridade das Alavancas Estratégicas.

Com essas aprovações realizadas pela utilização inicial e visibilidade da atuação da solução, a Plataforma começa a ser configurada e um plano de ‘roll out’ sendo construída e alterada para a implementação modular na operação, equilibrando sempre o “Senso de Urgência” com um ambiente produtivo sem ruptura, e permitindo sua escalabilidade e interoperabilidade dentro da empresa.

3) Algoritmo de Modelagem em Tempo Real.

Há muitas dúvidas sobre o Algoritmo de Modelagem em Tempo Real, sendo a principal delas:

a) Devo construir um Algoritmo de Modelagem em Tempo Real para minha empresa, nenhum outro pode ser aplicado?

O Algoritmo em nosso caso (Dipsie Solutions) já está desenvolvido! O que conforme apresentamos acima, há necessidade de adaptação para a realidade de cada empresa, pois os processos indústria e equipamentos e formas de tomada de decisão são diferentes, sendo necessários a inclusão dos dispositivos e formas de atuação.

b) Quanto tempo leva para implementar?

O tempo de implementação é bastante relativo aos objetivos de cada empresa, por isso a melhor estratégia é uma implementação modular, sendo que os maiores esforços não estão dentro da área produtiva, mas no desenho de atuação e simulação de cenários, onde de maneira muito simples, as empresas podem iniciar com a área produtiva obtendo desde já um aumento de performance e resultados que irão justificar a continuidade das aplicações.

O tempo estimado hoje é de 06 a 09 (meses) para se ter a implementação nos sistemas de e máquinas de controle industrial e as primeiras análise de fatores e externos e de planejamento de produção, sendo posterior a isso novas implementações e análises de fatores externos bem como simulações desejadas por outras áreas.

c) A solução é em Nuvem?

É fascinante o uso dos serviços de computação pois oferecem a capacidade de padronizar e simplificar a entrega de serviços computacionais bem como a integração de informações independentemente da sua localização geográfica e dos limites físicos e de infraestrutura computacional, além dos custos serem bastante atrativos. Mas se analisarmos as necessidade de segurança, houve a necessidade da construção da solução de forma híbrida, permitindo a segurança de dados e principalmente de conectividade, imagine cair ou oscilar a internet por pouco tempo que seja em um ambiente onde há uma solução que faz todo o controle fabril? Ou até mesmo dados preciosos os quais as empresas não querem que sejam guardados ou disponibilizados em sistemas de terceiros?

De forma que foi necessário garantir a Soberania, Segurança e Conformidade de dados e a Segurança de Conectividade para a operação de processos críticos, há necessidade de que a solução seja construída de forma híbrida (Local e Nuvem) para entregar instâncias diferentes na nuvem e no local. A solução local anula problemas de latência, pois permite a execução sem a necessidade de envio e retorno para a nuvem para o procedimento de modelamento, atuando de forma independente da nuvem com alto desempenho e modernidade nos controles industriais.

4) Como foi construído e desenvolvido o Algoritmo de Otimização em Tempo Real.

Abaixo apresentamos as técnicas utilizadas e os desafios para o desenvolvimento do Algoritmo Genético Híbrido desenvolvido para a Otimização em Tempo Real.

ALGORITMO GENÉTICO

O trabalho de Plucenio et al. (2004), sobre o problema de otimização da prospecção de petróleo off-shore, que apresentava estrutura similar ao problema tratado para o Desenvolvimento do Algoritmo Genético. O Algoritmo Genético criado é utilizado para determinar a alocação ótima de poços de petróleo off-shore, com o objetivo de aumentar o total de hidrocarbonetos produzido. Para tanto, eram manipuladas variáveis de decisão, como localização, taxa de injeção e taxa de produção e estas variáveis eram avaliadas em um simulador que prediz o comportamento dos poços. A transferência de informações e avaliações do simulador também aumentava muito o tempo computacional e, por conta disso, o Algoritmo Genético foi hibridizado com o método do Politopo que reduziu a necessidade computacional que antes leva horas e até mesmo dias para realizar a análise.

Este método que será descrito na sequência, possui a grande vantagem de ter sido desenvolvido antes da popularização dos microcomputadores e usar uma análise geométrica da região, não necessitando o cálculo de derivadas e mantendo a capacidade do algoritmo de lidar com quaisquer tipos de plantas.

O Algoritmo Genético desenvolvido neste trabalho anterior foi então hibridizado com um método determinístico conhecido como método do Politopo ou Algoritmo do Politopo (AP). O transformando-o em um Algoritmo Genético Híbrido (AGH).

Dada a pluralidade de cenários encontrados, estas variáveis são diversas em cada um deles e o algoritmo deverá ser genético o suficiente para resolver cada um dos problemas que forem simulados, sem a necessidade de muitos ajustes adicionais. Além do algoritmo ter de lidar com esta variedade de processos, a modelagem genética do problema leva a um equacionamento de certa complexidade, que necessita de um método de solução robusto.

Analisando este cenário, buscou-se um método de otimização robusto que não necessitasse o cálculo de derivada da função, uma vez que estas poderiam mudar de acordo com o cenário que este será modelado, assim, a utilização de métodos não determinísticos despontou como a melhor alternativa para este caso, uma vez que não necessitam do cálculo da derivada e lidam de forma eficiente com equacionamentos de alta complexidade.

Dentre os métodos não determinísticos mais utilizados, os Algoritmos Genéticos (AG) se destacam, tendo sido aplicados em diversos problemas de otimização ao longo de anos, com resultados bastante promissores e interessantes. O conhecimento deste tipo de algoritmo e experiência com estes em trabalhos anteriores foi o fator determinante na decisão da escolha deste método para nosso desenvolvimento.

Este AG se baseia no trabalho de Holland (1975), porém utiliza o sistema de codificação real. Sendo que primeiramente foi utilizado um AG puro, com ajustes nos operadores genéticos propostos por Michalewicz (1995).

Nossa primeira versão se mostrou capaz de otimizar o problema em questão, porém o tempo computacional para que se chegasse ao ótimo era elevado, pois para garantir a diversidade e evitar paradas em mínimos locais, a pressão sobre o operador de mutação é muito elevada. Com isso, o algoritmo demora a se estabilizar e necessitava de muitas avaliações da função objetivo.

Essas avaliações da função objetivo significavam acionar a um software simulador comercial, para obter, por exemplo, o comportamento termodinâmico e fluidodinâmico do processo, para o conjunto de variáveis geradas para cada indivíduo, em cada geração do operador genético. Esta avaliação necessita que informações do conjunto de variáveis sejam transferidas do software codificado e que este calculasse o equilíbrio e retorna-se os resultados ao software. Todo este processo tinha um custo em tempo computacional muito alto, desta forma, quanto mais vezes se acionava o simulador, maior era o tempo computacional para fornecer a solução. Com isso, a primeira versão do software de otimização levava mais de 30 horas para se chegar ao custo ótimo de produção em um microcomputador Intel Core 2 Quad 2.83 GHz, com 4 MB de RAM.

O elevado tempo computacional era então um problema grave na utilização do Algoritmo Genético puro. Algumas variações do algoritmo foram testadas, mas não conseguimos uma melhora significativa no tempo de processamento. A solução encontrada foi “hibridizar” o Algoritmo Genético para que houvesse um direcionamento da solução e então fossem reduzidas as avaliações da função objetivo, e consequentemente, o tempo computacional.

O grande problema nesta estratégia foi que a hibridização se dava acoplando métodos determinísticos ao Algoritmo Genético. O que retomava a necessidade de cálculo de derivadas e não permitia a generalização do algoritmo para todo do tipo de layout.

O Algoritmo Genético desenvolvido neste trabalho foi então hibridizado com um método determinístico conhecido como método do Politopo ou Algoritmo do Politopo (AP). O objetivo desta hibridização foi direcionar a solução do Algoritmo Genético, transformando-o em um Algoritmo Genético Híbrido (AGH) e melhorando assim sua convergência e reduzindo o tempo computacional, tornando-o muito mais eficiente, de maneira a qual o tempo de resposta hoje é menor de 10ms.

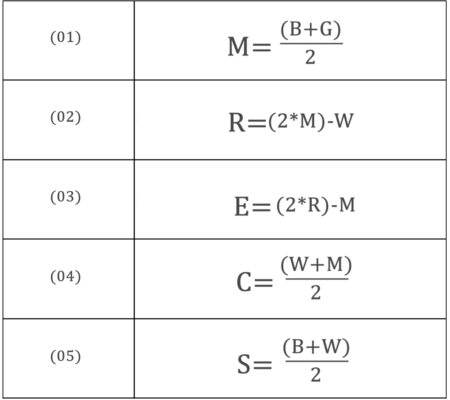

ALGORITMO DE POLITOPO

Um politopo é uma figura geométrica na dimensão n constituída de segmentos de linha interconectando seus n+1 vértices. Em duas dimensões um politopo é um triângulo, em três dimensões um tetraedro e assim por diante. A cada passo do algoritmo, um novo vértice é gerado. Se o novo vértice é melhor do que pelo menos um dos vértices existentes, ele substitui o pior vértice.

Pode-se dizer que nosso algoritmo “tateia” o espaço de busca ao redor dos vértices, seguindo o equacionamento descrito na sequência. Ao vasculhar este espaço próximo aos vértices, ele encontra o caminho que leva a minimização do valor da função objetivo e direciona a solução neste caminho.

Este algoritmo sozinho também apresenta como desvantagem demandar muitas avaliações da função objetivo, o que corresponderia acionar o simulador muitas vezes. No entanto, as soluções que são obtidas através dele são muito úteis no sentido de gerar indivíduos mais aptos para a nova população do Algoritmo Genético, reduzindo a necessidade e muitas gerações do Algoritmo Genético e, por consequência, reduzindo o tempo computacional necessário para a otimização como um todo.

O Algoritmo Politopo conta com uma série de funções que são executadas em sequência, seguindo um algoritmo pré-definido e que modificam os vértices dos triângulos. Cada mudança gera um novo vértice que é avaliado na função objetivo.

As funções executadas segundo o algoritmo para realizar as modificações dos vértices estão descritas nas equações de (01) a (05):

Onde, B, G e W são o Melhor, Bom e Pior vértices respectivamente do triângulo no início da busca.

A representação gráfica das modificações promovidas pelas funções em cada um dos vértices pode ser observada nas Figuras abaixo.

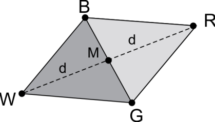

Triângulo BGW e ponto médio M e ponto de reflexão R – Fonte: Plucenio et al. (2004)

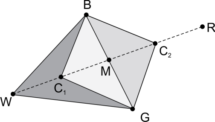

Ponto de contração C1 e C2 – Fonte: Plucenio et al. (2004)

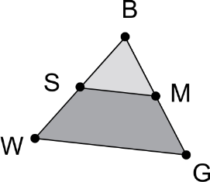

Redução do triângulo na direção de B – Fonte: Plucenio et al. (2004)

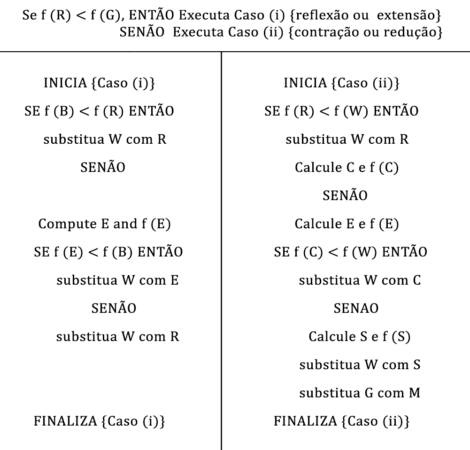

O algoritmo para executar as modificações nos vértices segundo o método de Nelder-Mead está descrito na Tabela abaixo.

Construção do Algoritmo Genético Híbrido

Resolvemos o problema de otimização de plantas de produção como um todo utilizando as técnicas de desenvolvimento de Algoritmos Genéticos, obtendo a capacidade de adaptação a problemas de difíceis soluções como problemas não-lineares e de difíceis expressão de derivada.

No entanto, foi necessário incluir um método de busca local para promover um refinamento da solução final. O processo de minimização foi alcançado através da interação dos operadores evolutivos, direcionados pelo Algoritmo de Politopo. Criando-se um Algoritmo Genético Hibrido.

Nosso Algoritmo Genético Híbrido desenvolvido reúne conceitos dos Algoritmos Genéticos tradicionais, como a criação de uma população inicial de indivíduos, aleatoriamente, e os operadores básicos, com cruzamento e mutação, porém, difere dos Algoritmos Genéticos tradicionais pelo direcionamento para região ótima, obtido com a utilização do Algoritmo de Politopo, deixando assim de possuir caráter puramente aleatório e passando a também seguir regras determinísticas.

O algoritmo se inicia pela geração da população inicial, população esta gerada de modo randômico dentro das faixas operacionais das variáveis. Estas faixas operacionais são determinadas pelo usuário para cada cenário simulado e inseridas por ele no software. Uma vez criada a população inicial, esta passa por cada um dos operadores genéticos demonstrados na sequência.

Em cada um dos operadores, os indivíduos gerados são avaliados junto à função objetivo. As respostas da função objetivo são dadas em termos de vazão de produtos e matérias-primas e devem ser indexadas em termos de custo.

Apesar do Algoritmo Genético gerar como indivíduos variáveis de processo, a otimização se dá no resultado de custo que tais indivíduos retornam quando avaliados junto à modelagem de todo o processo. A resposta da modelagem em termos de vazões é traduzida para custo por uma equação.

Após o cruzamento, ocorre o primeiro direcionamento pelo Algoritmo de Politopo, que nesta etapa tem a função de direcionar os indivíduos que podem ou não sofrer mutação. A mutação pode ou não ocorrer a cada geração. A decisão de ocorrência fica a cargo de uma variável binária gerada aleatoriamente a cada geração. Após a mutação, os indivíduos são novamente direcionados pelo Algoritmo de Politopo.

Na sequência ocorre a Seleção por Torneio, onde aqueles que obtiveram melhor resultado, no caso o menor, junto da função objetivo prosseguem e serão escolhidos para formar a nova população inicial.

Os melhores indivíduos selecionados e os com resultados intermediários são novamente submetidos ao Algoritmo de Politopo. Esta etapa visa vasculhar o espaço de busca onde se encontram os indivíduos mais aptos, objetivando encontrar um caminho que melhore a otimização como um todo.

Como o método é multidirecional, a avaliação dos resultados intermediários também pode levar a um caminho de busca mais eficiente e é por este motivo que estes também estão sendo avaliados no Algoritmo de Politopo.

O algoritmo segue até que o critério de parada, que neste caso é o número de iterações sem alterações no valor ótimo, seja satisfeito.

A diversidade é mantida por novos indivíduos gerados no operador de mutação, quando este operador ocorre.

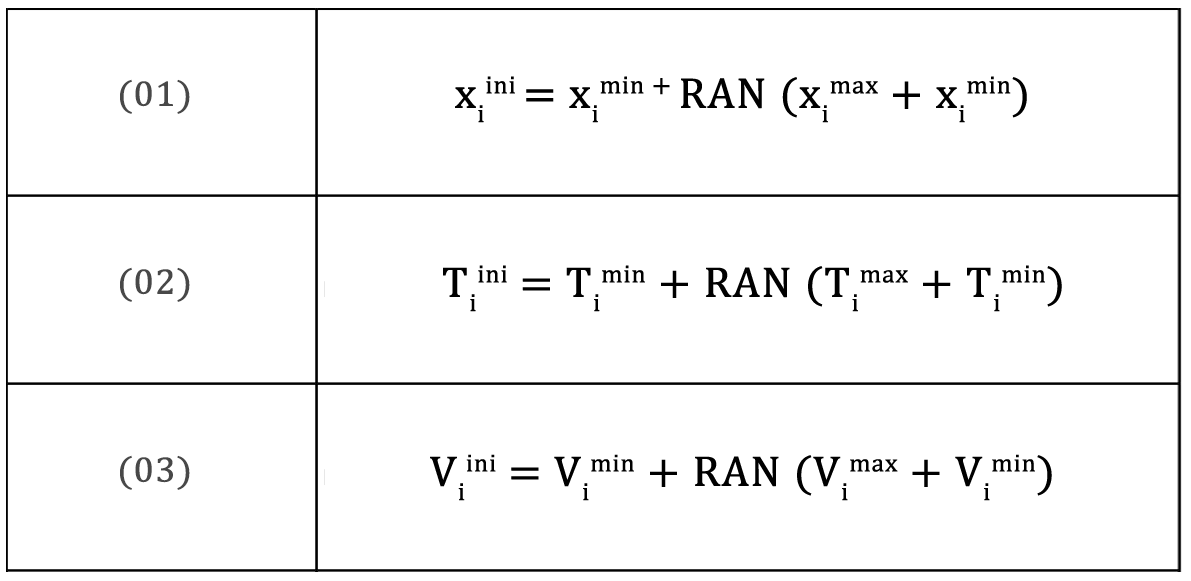

Os indivíduos da população inicial são variáveis manipuláveis do processo produtivo que têm sua influência sobre o custo final do produto e estão representados por números reais. A população inicial é encontrada pelas Equações de (01) a (03) abaixo:

onde RAN é um número randômico.

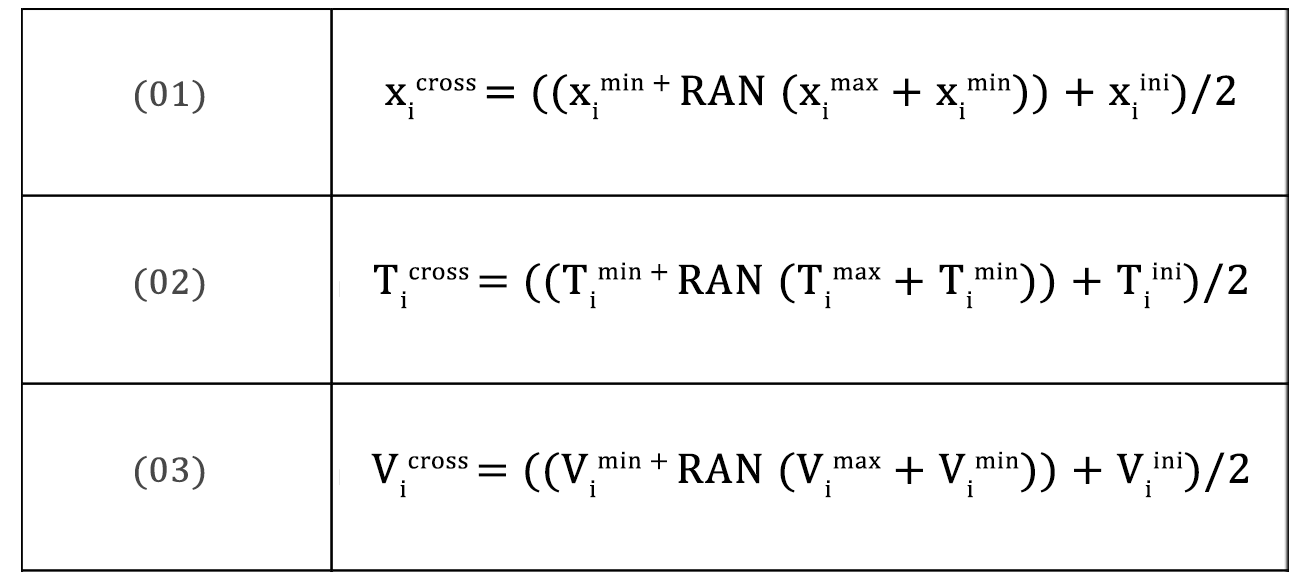

Operador de cruzamento

O operador de cruzamento é representado por uma operação aritmética realizada entre os indivíduos da população inicial e novos, gerados dentro das restrições impostas na modelagem do problema como apresentado nas Equações de (01) a (03) abaixo.

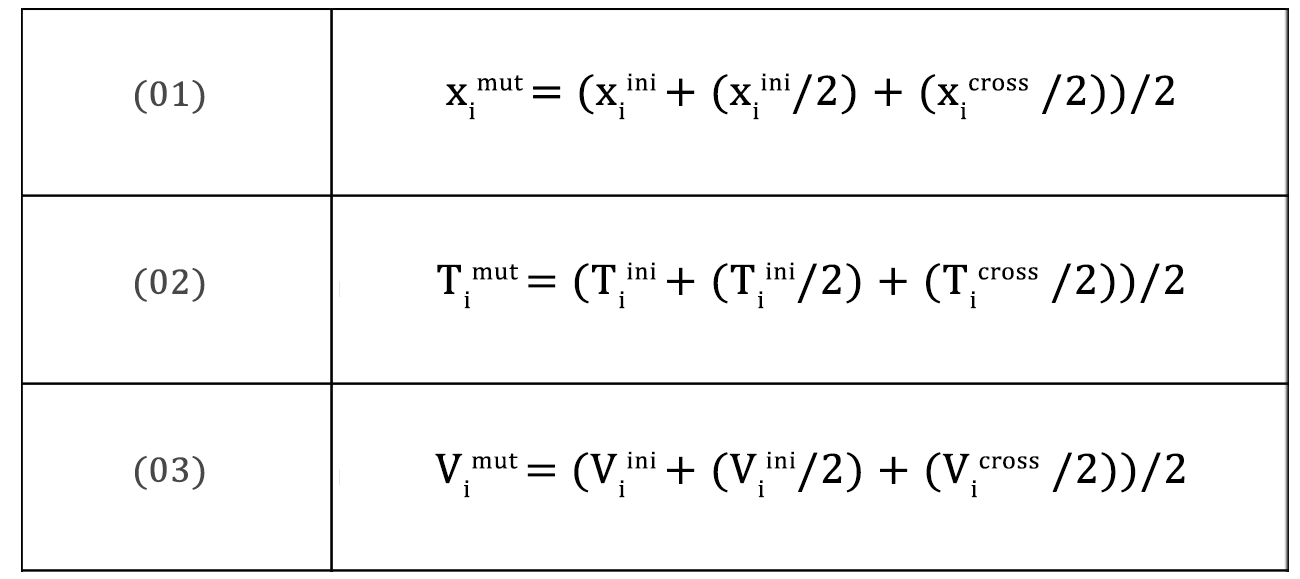

Operador de mutação

A mutação é a operação que envolve tanto os indivíduos iniciais, quanto os obtidos pelo operador de cruzamento, porém não deixando de gerar novos para manter a diversidade da população, sempre atendendo às restrições da modelagem do processo, como demonstrado nas Equações de (01) a (03) abaixo:

Avaliação e Seleção

Os indivíduos são escalonados usando o método de Seleção por Torneio. Dois indivíduos são comparados e suas aptidões são avaliadas, sendo o mais apto é o selecionado. Os indivíduos selecionados formam a população inicial da nova geração, respeitando o tamanho da população especificada nos parâmetros do AG. Tem-se assim o uso do Elitismo, que tende a aumentar rapidamente o desempenho do AG, e ainda previne a perda da melhor solução já encontrada.

Critério de Parada

O processo se repete pelas iterações do algoritmo até que o número de iterações sem melhora no valor ótimo seja alcançado.

É importante salientar que o número de iterações influi no resultado final da otimização. Este é um parâmetro avaliado em sua influência no resultado em relação ao custo do tempo computacional.

Para alcançar os resultados, foi determinado que o AGH seria executado por 200 iterações no mínimo e este pararia se houvesse 200 iterações sem melhora do valor ótimo.

Quer saber mais? Entre em contato com nosso time e conheça o X-Machine RTO (Nossa plataforma de software com modelagem para Otimização Global em Tempo Real). Auxiliando deste o Planejamento e Controle até os ajustes sistêmicos e de máquinas de toda a cadeia produtiva.

Acesse e Conheça: